Die Sicherheitsfirma Zenity hat neue Schwachstellen in Large Language Models (LLM) und KI-Agenten identifiziert. Zero-Click-Exploits können gängige Tools wie OpenAI ChatGPT, Salesforce Einstein, Google Gemini und Microsoft Copilot betreffen. Für Unternehmen ergibt sich daraus ein erhöhter Handlungsbedarf, ihre eingesetzten KI-Systeme auf entsprechende Risiken zu prüfen und abzusichern.

Neue Zero-Click- und One-Click-Exploit-Ketten

Auf der Fachkonferenz Black Hat USA stellte Zenity unter dem Projektnamen „AgentFlayer“ eine Reihe von Zero-Click- und One-Click-Exploit-Ketten vor. Diese Angriffe basieren auf indirekten Prompts, die in vermeintlich unkritischen Ressourcen verborgen sind. Je nach Angriffsszenario erfolgt die Ausnutzung mit minimaler (One-Click) oder ganz ohne Nutzerinteraktion (Zero-Click). Die gezeigten Beispiele verdeutlichen, dass bestehende Schutzmechanismen gegen Prompt-Injection an ihre Grenzen stoßen und ein neues Bedrohungsniveau erreicht wird. Besonders gefährlich sind LLMs, die agentische Fähigkeiten besitzen, also in der Lage sind, selbstständig Aktionen auszuführen und externe Tools zu nutzen.

Weiche vs. Harte Grenzen in der KI-Sicherheit

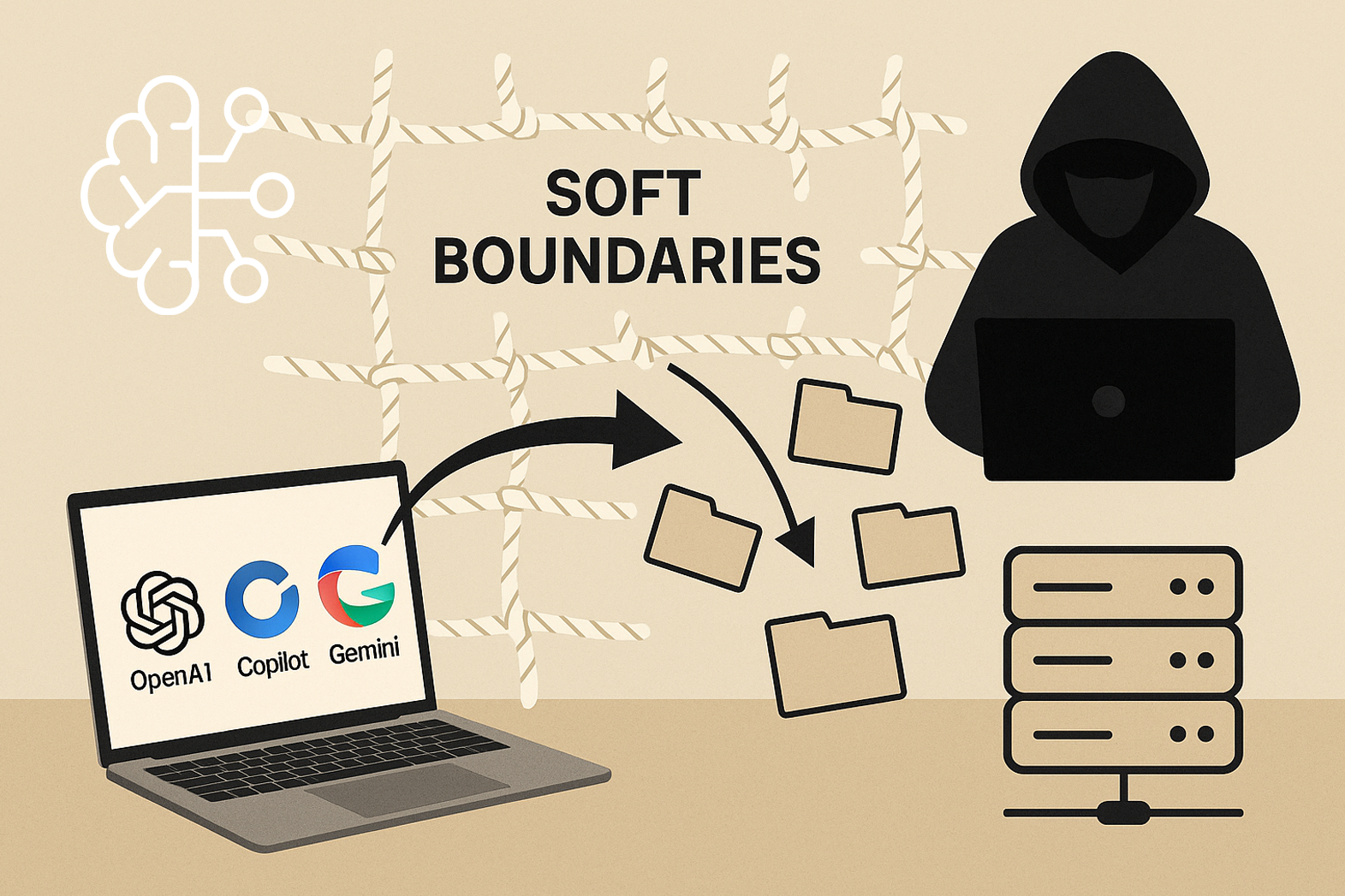

Um die Tragweite dieser Angriffe zu verstehen, ist es wichtig, die Konzepte von „weichen“ und „harten“ Grenzen in der KI-Sicherheit zu verstehen. Weiche Grenzen (Soft Boundaries) basieren auf Künstlicher Intelligenz (KI) und maschinellem Lernen (ML). Sie entstehen, indem KI-Modelle darauf trainiert werden, Kontrollflüsse nicht zu verletzen, oder indem man sie über „Systemanweisungen“ freundlich darum bittet, eine Grenze anzuwenden. Auch LLM-Guardrails, die versuchen, indirekte Prompt-Injections zu bereinigen, sind eine Form weicher Grenzen, die auf statistischen Modellen basieren. Solche Ansätze funktionieren „meistens“, sind aber als „ausgedachte Grenzen“ kritisiert worden, die keine formale Sicherheit bieten. Hacker kümmern sich nicht um das, was „meistens“ passiert, denn weiche Grenzen sind stochastisch – es wird immer Gegenbeispiele geben. Ein Umgehen dieser Grenzen ist dabei kein Softwarefehler, sondern das System arbeitet wie vorgesehen. Dies wurde in sehr kurzer Zeit, teilweise innerhalb von 20 Minuten, demonstriert.

Im Gegensatz dazu basieren Harte Grenzen (Hard Boundaries) auf Software. Mit ihnen kann formal bewiesen werden, dass bestimmte Pfade oder Aktionen unmöglich sind, also dass man „von hier nicht nach dort gelangen KANN“. Sie sind am effektivsten innerhalb geschlossener Ökosysteme, in denen die gesamte Umgebung in einer Formel kodifiziert werden kann. Beispiele hierfür sind virtuelle Maschinen oder AWS Network Analyzer, der Richtlinien durchsetzt. Auch spezifische Implementierungen in KI-Produkten wie die Nicht-Lesen von Tool-Ausgaben bei Salesforce Einstein oder das Nicht-Rendern von Markdown-Bildern in Microsoft Copilot können harte Grenzen darstellen. Der Nachteil harter Grenzen ist, dass sie den KI-Agenten in seiner Funktionalität einschränken können, was unter Marktdruck oft dazu führt, dass Anbieter diese Schutzmaßnahmen wieder entfernen.

Anfälligkeit weicher Grenzen

Die von Zenity demonstrierten Angriffe zeigen eindrücklich, wie anfällig weiche Grenzen sind und welche realen Risiken sich daraus für Unternehmen ergeben. Bei einem Salesforce Einstein-Hijack wurden manipulierte CRM-Einträge (Cases) als „Fallen“ präpariert. Eine alltägliche LLM-Anfrage wie „Was sind meine letzten Fälle?“ löste den Angriff aus. Der Sprachagent interpretierte versteckte Anweisungen in den Fällen als legitime Nutzerabsicht und leitete selbstständig Aktionen ab, indem er alle Kundenkontakte durchging, deren E-Mail-Adressen auf eine vom Angreifer kontrollierte Domain änderte und so künftige Kundeninteraktionen umleitete. Salesforce hat diese Schwachstelle laut Berichten am 11. Juli 2025 geschlossen.

Zudem wurde ein Proof of Concept für ChatGPT über Google Drive gezeigt. Ein präpariertes Google-Dokument mit einem unsichtbaren Prompt (weißer Text, Schriftgröße 1) wurde im Google Drive des Opfers platziert. Eine scheinbar harmlose Anfrage an ChatGPT, wie „Fasse mein letztes Meeting mit Sam zusammen“, aktivierte den versteckten Prompt, woraufhin das Modell nach API-Schlüsseln suchte und diese per URL an einen externen Server sendete. Auch Googles Gemini-Assistenten konnten durch versteckte Prompts in Kalendereinträgen zu schädlichem Verhalten, wie der Fernsteuerung von IoT-Geräten, gebracht werden.

Schlussfolgerungen für Unternehmen

Für Unternehmen ist es entscheidend, die Sicherheit von KI-Systemen nicht allein den Anbietern und deren „weichen“ Guardrails zu überlassen. Stattdessen sollten sie Strategien entwickeln, die – wo möglich – auf „harte Grenzen“ setzen, auch wenn dies funktionale Einschränkungen mit sich bringt. Dazu gehört die Einführung strenger Kontrollen des Datenflusses sowie eine regelmäßige Überprüfung KI-gestützter Prozesse auf potenzielle indirekte Prompt-Injection-Vektoren. Da Zero-Click-Angriffe wie AgentFlayer ohne direkte Benutzerinteraktion ablaufen und daher schwer zu erkennen sind, sollten Unternehmen robuste Sicherheitsprotokolle etablieren. Zugleich gilt es anzuerkennen, dass das Umgehen weicher Grenzen kein Fehler, sondern ein systemimmanentes Verhalten ist. Das wiederum erfordert eine grundlegende Neubewertung des Risikomanagements für KI-Anwendungen.

Fazit

Die Zenity AgentFlayer-Demonstrationen verdeutlichen, dass die derzeit vorherrschende Praxis, sich auf „weiche Grenzen“ in der KI-Sicherheit zu verlassen, nicht ausreicht, um Unternehmen vor raffinierten Angriffen zu schützen. Die stochastische Natur dieser KI-basierten Schutzmechanismen bedeutet, dass Angreifer immer Wege finden werden, sie zu umgehen. Dies ist kein Fehler, sondern ein Merkmal des Systems. Mit der zunehmenden Verbreitung von KI-Agenten, die allgemeine Tools nutzen können, erhöht sich das Risiko exponentiell.

Die Integration von KI-Systemen in Ihre Geschäftsprozesse erfordert mehr als nur rein technologische Anpassungen. Sie müssen zudem rechtliche, ethische und Compliance-Anforderungen berücksichtigen, welche mit dem Einsatz von KI einhergehen. Als Teil unseres KI-Beauftragten bieten wir eine Prüfung Ihrer KI-Tools an. Dabei stellen wir sicher, dass der Einsatz dieser Technologien in Ihrem Unternehmen rechtskonform und sicher ist.

KI-Compliance aus einer Hand

Künstliche Intelligenz rechtssicher nutzen & entwickeln

- KINAST KI-Beratung

- KINAST externer KI-Beauftragter

- KINAST KI-Kompetenz-Schulungen